고정 헤더 영역

상세 컨텐츠

본문

1. 하이퍼파라미터 튜닝기법

| 종류 | 설명 | 적용 시 고려사항 |

| 학습률 (Learning Rate) |

gradient의 방향으로 얼마나 빠르게 이동할 것인지 결정하는 변수 | – 너무 작으면 학습의 속도가 늦고, 너무 크면 학습 불가 |

| 손실 함수 (Cost Function) |

입력에 따른 기대 값과 실제 값의 차이를 계산하는 함수 | – 평균 제곱 오차 – 교차 엔트로피 오차 |

| 정규화 파라미터 (Regularization parameter) |

L1 또는 L2 정규화 방법 사용 | – 사용하는 일반화 변수도 하이퍼 파라미터로 분류 |

| 미니 배치 크기 (Mini-batch Size) |

배치셋 수행을 위해 전체 학습 데이터를 등분하는(나누는) 크기 | – 가용 메모리 크기와 epoch 수행 성능을 고려 – 최소 사이즈 : 32 / * 참조논문( arxiv.org/abs/1804.07612) – 배치 크기는 GPU의 물리적인 구조로 인해 항상 2의 제곱으로 설정 |

| 훈련 조기 종료 (Early Stopping) |

학습의 조기 종료를 결정하는 변수 | – 학습 효율이 떨어지는 시점을 적절히 판단 |

| 은닉층의 뉴런 개수 (Hidden Unit) |

훈련 데이터에 대한 학습 최적화 결정 변수 | – 첫 Hidden Layer의 뉴런 수가 Input Layer 보다 큰 것이 효과적 |

| 가중치 초기화 (Weight Initialization) |

학습 성능에 대한 결정 변수 | – 모든 초기값이 0일 경우 모든 뉴런이 동일한 결과 |

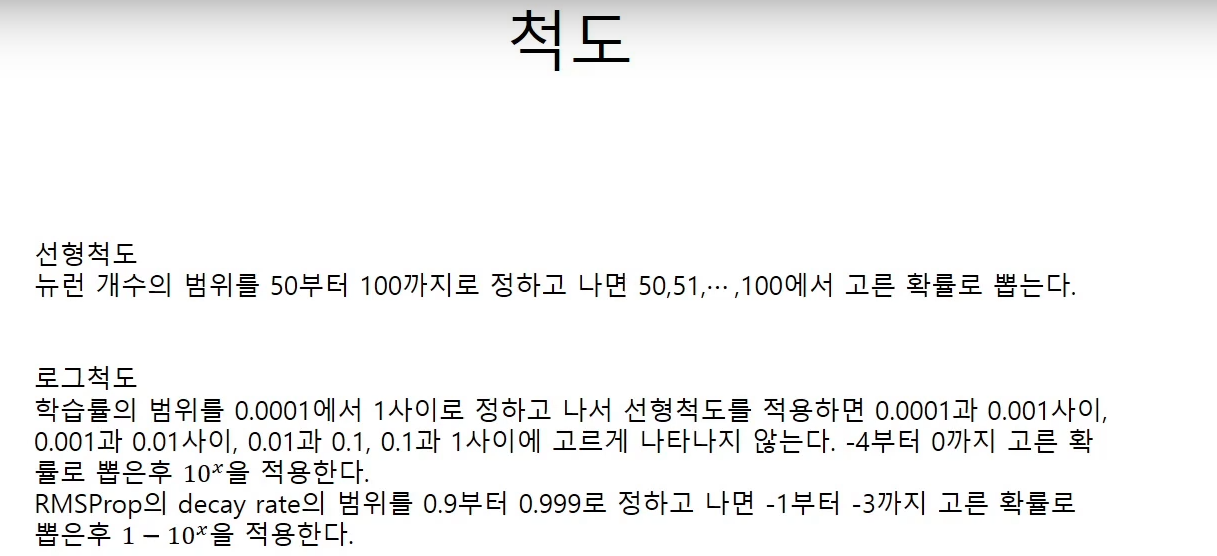

훈련용데이터, 검증데이터, 테스트 데이터로 3분할을 한다. 예를들어 러닝레이트 하나를 잡아서 100개를 훈련용데이터로 훈련시키고 검증데이터로 성능을 측정을 한다. 그리고 그 중 가장 성능이 좋은 데이터를 선정해서 다시 훈련을 시킨다. 그리고 다시 검증한다. 이걸 반복한다. 하지만 성능은 훈련데이터로 시험한다.

'딥러닝 기초 이론 > 밑바닥부터 시작하는 딥러닝 이론' 카테고리의 다른 글

| 22.MAX POOLING (0) | 2023.02.05 |

|---|---|

| 21. 텐서 (0) | 2023.02.01 |

| 19.과적합 (0) | 2023.01.31 |

| 18.배치 정규화 (0) | 2023.01.30 |

| 17.Xavier/He 초기값 (0) | 2023.01.27 |